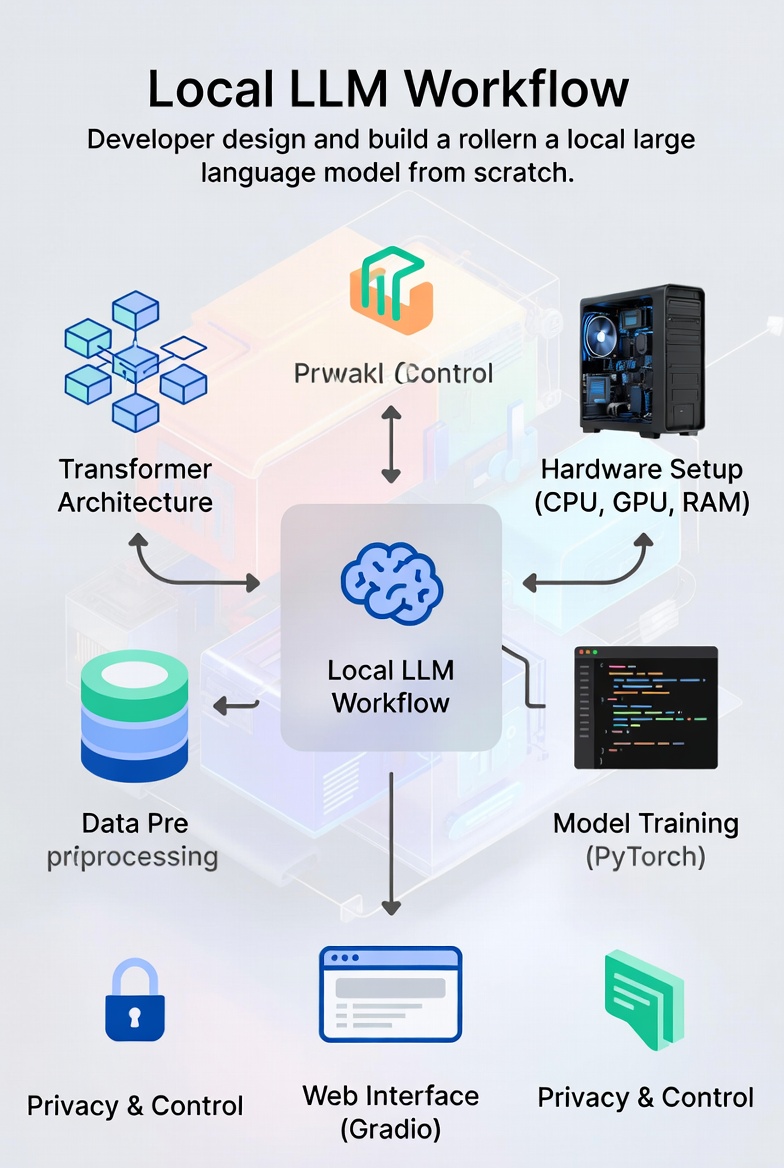

如何从头设计和构建本地大语言模型

2026年一月14日 · 大语言模型 机器学习 自然语言处理 本地AI 变换器架构

如何从头设计和构建本地大语言模型

介绍

随着模型架构、训练技术和硬件加速的进步,构建在本地运行的大语言模型(LLM)变得越来越可行。与基于云的模型不同,本地LLM提供以下优势:

- 隐私性:数据不会离开您的设备

- 控制权:完全定制模型行为

- 成本效益:无需API调用或订阅费用

- 离线访问:无需互联网连接即可工作

本指南提供了一个全面的、分步的方法来设计和实现功能强大的本地LLM,适合具有中级机器学习知识的开发者。

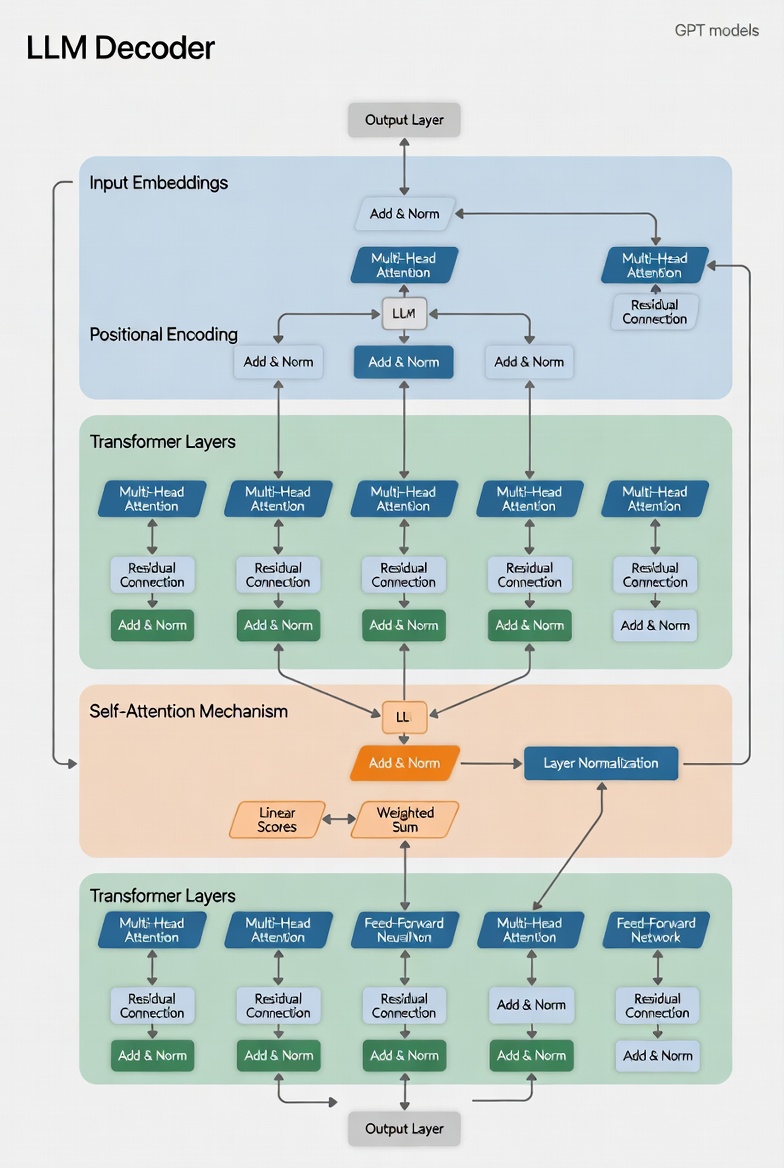

1. 基础:理解LLM架构

1.1 变换器基础

现代LLM基于Attention Is All You Need(Vaswani等人,2017)中介绍的变换器架构构建。核心创新是自注意力,它允许模型在上下文中权衡不同标记的重要性:

\[ext{Attention}(Q, K, V) = ext{softmax}\left(\frac{QK^T}{\sqrt{d_k}}\right)V\]其中:

- $Q$ = 查询矩阵(我们要寻找的内容)

- $K$ = 键矩阵(我们已有的内容)

- $V$ = 值矩阵(我们返回的内容)

- $d_k$ = 键的维度

1.2 仅解码器架构

对于本地LLM,我们将专注于仅解码器架构(如GPT模型),因为:

- 它们比编码器-解码器模型更简单

- 它们对文本生成任务更高效

- 它们需要较少的计算资源

2. 设计阶段:定义模型需求

2.1 硬件考虑

开始之前,请评估您可用的硬件:

| 硬件组件 | 最低要求 | 推荐配置 |

|---|---|---|

| CPU | 8核,2.5 GHz+ | 16核,3.5 GHz+ |

| GPU | 8GB VRAM (NVIDIA) | 24GB+ VRAM (NVIDIA RTX 3090/4090) |

| RAM | 16GB | 64GB+ |

| 存储 | 100GB SSD | 2TB NVMe SSD |

2.2 模型规格

根据您的用例选择适当的模型超参数:

| 超参数 | 小型模型 | 中型模型 | 大型模型 |

|---|---|---|---|

| 嵌入大小 | 768 | 1024 | 2048 |

| 层数 | 12 | 24 | 32 |

| 注意力头数 | 12 | 16 | 32 |

| 隐藏层大小 | 3072 | 4096 | 8192 |

| 序列长度 | 512 | 1024 | 2048 |

| 参数数量 | 110M | 700M | 1.3B |

注:对于本地部署,目标是700M-1.3B参数,以获得质量和性能的良好平衡。

3. 实现阶段:构建模型

3.1 设置开发环境

首先,创建一个带有必要依赖项的Python环境:

# 创建并激活环境

conda create -n local-llm python=3.10

conda activate local-llm

# 安装核心依赖项

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu121

pip install transformers datasets tokenizers sentencepiece

pip install accelerate bitsandbytes peft

pip install numpy pandas matplotlib tqdm

3.2 分词器

实现自定义分词器或为您的用例调整现有分词器:

from tokenizers import Tokenizer

from tokenizers.models import BPE

from tokenizers.trainers import BpeTrainer

from tokenizers.pre_tokenizers import Whitespace

# 初始化分词器

tokenizer = Tokenizer(BPE(unk_token="<UNK>"))

tokenizer.pre_tokenizer = Whitespace()

trainer = BpeTrainer(

vocab_size=50000,

special_tokens=[

"<PAD>",

"<UNK>",

"<CLS>",

"<SEP>",

"<MASK>",

"<BOS>",

"<EOS>"

]

)

# 在您的数据集上训练分词器

tokenizer.train(files=["data.txt"], trainer=trainer)

# 保存分词器

tokenizer.save("local-llm-tokenizer.json")

4. 训练阶段:准备和使用数据

4.1 数据收集

收集多样化的文本语料库用于训练:

- 开源数据集:

- 数据过滤:

- 移除重复数据

- 过滤低质量内容

- 规范化编码

- 分词并分割成块

5. 优化阶段:使其在本地运行

5.1 模型量化

减少模型大小并提高推理速度:

# 动态量化

quantized_model = torch.quantization.quantize_dynamic(

model,

{nn.Linear}, # 要量化的层

dtype=torch.qint8 # 量化类型

)

# 保存量化模型

torch.save(quantized_model.state_dict(), "local-llm-quantized.pth")

6. 部署阶段:创建本地界面

6.1 使用Gradio的Web界面

创建一个简单的本地使用Web界面:

import gradio as gr

def generate(prompt, max_length, temperature, top_k):

return generate_text(prompt, max_length=max_length, temperature=temperature, top_k=top_k)

# 创建Gradio界面

interface = gr.Interface(

fn=generate,

inputs=[

gr.Textbox(label="提示词", placeholder="在此处输入您的提示词..."),

gr.Slider(minimum=50, maximum=500, value=200, label="最大长度"),

gr.Slider(minimum=0.1, maximum=2.0, value=0.7, label="温度"),

gr.Slider(minimum=10, maximum=100, value=50, label="Top-K")

],

outputs=gr.Textbox(label="生成文本"),

title="本地LLM界面",

description="一个本地托管的大语言模型,用于文本生成。",

theme="huggingface"

)

# 启动界面

interface.launch(share=False) # 设置为True可公开分享(需要互联网)

7. 结论

从头构建本地LLM是一个具有挑战性但有益的项目,可以深入了解现代AI技术。通过遵循本指南,您可以创建一个功能强大的模型,根据您的特定需求进行定制,同时保持对数据和基础设施的完全控制。

请记住,成功需要耐心、实验和持续学习。从小规模开始,经常迭代,不要害怕根据经验调整您的方法。

“学习的最好方法是实践。” — Andrew Ng